- SnaqNews

- Posts

- O custo da IA: impactos práticos para quem toma decisões de tecnologia

O custo da IA: impactos práticos para quem toma decisões de tecnologia

E mais: novo GPT-5.1 deixa ChatGPT mais humano

Bom dia!

Hoje é dia de edição especial do Radar de IA. A cada 15 dias no seu e-mail, um resumo claro e direto das novidades mais importantes em ferramentas e aplicações de IA.

O que você vai ver nesta edição:

Opinião “O custo da IA: entre alavancagem e eficiência e o impacto para decisores”

Novo GPT-5.1 deixa ChatGPT mais humano

Google quer infraestrutura de IA em órbita usando luz solar

Novos lançamentos de modelos e ferramentas

OPINIÃO

O CUSTO DA IA: ENTRE ALAVANCAGEM E EFICIÊNCIA E O IMPACTO PARA QUEM TOMA DECISÕES DE TECNOLOGIA

O mercado de IA entrou em uma nova fase financeira. Antes o foco era capacidade dos modelos.

Agora também é a “engenharia econômica e financeira” necessária para sustentar a infraestrutura de IA.

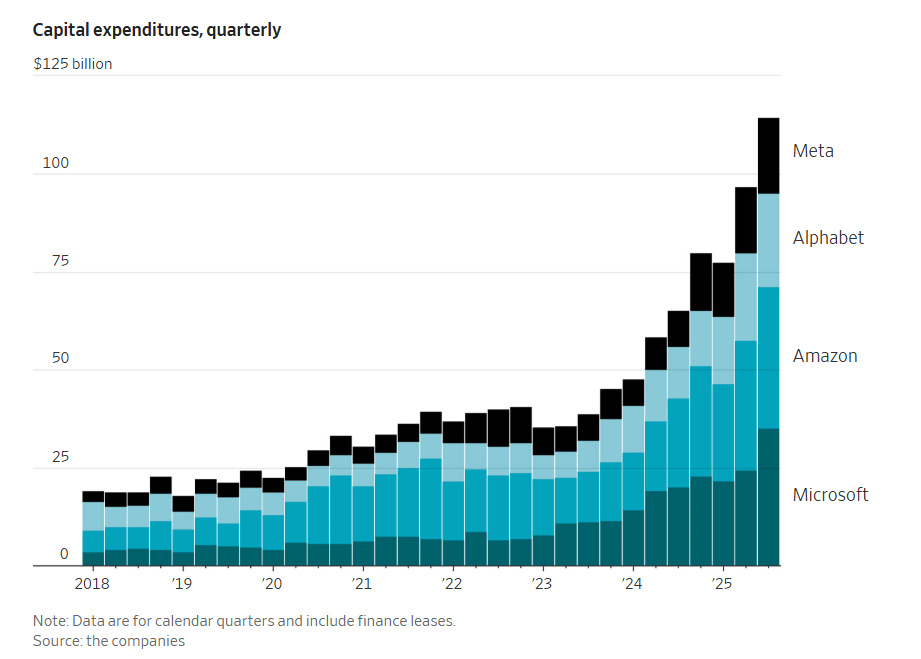

Quanto está custando? As big techs projetam um gasto de mais de US$ 400 bilhões em infraestrutura (hardware e data centers) neste ano. A demanda por capacidade computacional continua superando a oferta.

Fonte: WSJ

De onde vem o dinheiro? Apesar de as empresas terem caixa, elas buscam formas de manter o balanço positivo, usando crédito "inteligente". A Blackstone, por exemplo, financia data centers usando aluguéis e os ativos como garantia. Estratégias similares de alavancagem são usadas por outras empresas.

Com esse cenário, existem dois movimentos de expansão das empresas de AI e das suas escolhas de investimento, que são bem explicados pelas estratégias de OpenAI e Anthropic.

OpenAI: mantém uma estratégia de expansão agressiva, com projeções de prejuízos operacionais até 2029 devido ao alto custo de computação para buscar liderança de mercado.

Anthropic: sinaliza uma rota voltada para a eficiência de capital, com projeções internas indicando possibilidade de lucro já em 2028 e um foco maior em margens sustentáveis.

A necessidade de capital intensivo está forçando o mercado a sair do modo "aventura" para o modo "industrial".

Isso traz três leituras importantes para lideranças de tecnologia:

O uso de instrumentos de dívida atrelados a data centers indica que o setor espera fluxos de caixa constantes e previsíveis no longo prazo. Isso sugere que a era dos subsídios pesados, onde o custo da inferência era artificialmente baixo para ganhar mercado, pode dar lugar a uma precificação mais racional e elevada no futuro.

A divergência entre OpenAI e Anthropic não é apenas financeira, mas de produto. A OpenAI parece apostar que a escala massiva (e cara) desbloqueará novas capacidades inéditas. A Anthropic parece apostar que a otimização e a integração corporativa (B2B) trarão o retorno mais rápido.

Para quem contrata essas tecnologias, a saúde financeira do fornecedor passa a ser um critério de seleção. Em um cenário de juros altos ou retração de crédito, empresas com "unit economics" mais saudáveis oferecem menor risco de descontinuidade de serviço.

A construção da infraestrutura de IA segue acelerada, mas a conta ficou alta demais para ser paga apenas com capital de risco. O mercado está se sofisticando, e a sustentabilidade financeira das operações começa a pesar tanto quanto a inteligência dos algoritmos.

GIRO DE NOTÍCIAS

NOVO GPT-5.1 DEIXA CHATGPT MAIS HUMANO

O GPT-5.1 é a primeira grande atualização da linha GPT-5 e chega em duas versões principais: Instant - modelo padrão de chat, e Thinking - voltado para raciocínio avançado.

O grande salto técnico é o raciocínio adaptativo. Tanto o Instant quanto o Thinking agora “decidem” quando precisam pensar mais antes de responder, usando mais tempo em problemas complexos e sendo mais rápidos em perguntas simples.

No ChatGPT, o modelo GPT-5.1 passa a ser o novo padrão: o modo Auto continua roteando automaticamente cada pedido para o modelo mais adequado, enquanto o Instant e o Thinking vão sendo liberados primeiro para usuários pagos e depois para todos.

A OpenAI também está reforçando a camada de personalização de “personalidade” do ChatGPT: além de estilos como Default, Friendly e Efficient, entram novos modos como Professional, Candid e Quirky.

A ideia é que cada pessoa consiga moldar o jeito de falar do modelo ao seu gosto, sem abrir mão dos ganhos de raciocínio do GPT-5.1.

MOONSHOT KIMI K2 THINKING

A Moonshot AI lançou o Kimi K2 Thinking, uma nova versão do Kimi K2, focada em raciocínio passo a passo e uso intenso de ferramentas. O modelo é projetado como um agente que combina cadeia de raciocínio (CoT) com chamadas de função para pesquisar na web, escrever código e montar respostas longas e estruturadas.

Na prática, ele consegue executar entre 200 e 300 chamadas de ferramentas em sequência mantendo coerência, algo bem acima dos 30–50 passos suportados pela maioria dos modelos atuais.

Em benchmarks, o K2 Thinking chega muito perto (ou empata) com modelos fechados de topo em tarefas de matemática, provas olímpicas e raciocínio, como AIME 2025, HMMT e GPQA, e se destaca em cenários com chamadas de ferramentas encadeadas.

Performance nos benchmarks, divulgação Kimi.

Assim como o modelo anterior, o Kimi K2 Thinking é aberto e já disponível em diversos provedores (OpenRouter, Together e Ollama), facilitando a adoção sem depender totalmente de APIs fechadas.

VOLTA RÁPIDA

Google está desenvolvendo o Project Suncatcher, que visa criar infraestrutura de IA em órbita, usando TPUs (similares a GPUs, mas desenvolvidas pelo próprio Google) por energia solar. No projeto, os satélites com clusters de TPUs orbitaram a Terra, conectados por lasers, treinando modelos em estruturas alimentadas por luz solar constante.

Esses satélites podem coletar até 8x mais energia que na Terra e funcionariam quase 24h/dia.

Testes iniciais mostram que as TPUs são tolerantes à radiação espacial e comunicação óptica deve ser estável entre satélites.

Caso os custos de lançamento caiam para menos de US$ 200/kg, a computação orbital pode custar próximo do valor de datacenters na Terra, o que já tornaria o projeto viável financeiramente. Segundo o cronograma, dois protótipos devem ser lançados ainda em 2027.

A Snap e a Perplexity fecharam um acordo de US$ 400 milhões para colocar o motor de busca por IA no Snapchat a partir de 2026. O usuário poderá fazer perguntas em linguagem natural dentro do chat e receber respostas com citações e fontes verificáveis, sem sair do app.

O movimento é estratégico para os dois lados: a Perplexity compra distribuição para quase 1 bilhão de usuários mensais, e a Snap cria uma nova fonte de receita além da publicidade, num modelo em que a empresa de IA paga à rede social pelo acesso à audiência.

Com a nova capacidade, o Copilot (agente da Microsoft) agora consegue operar um “computador na nuvem” totalmente isolado.

O que muda? Isso permite navegação e interação em sites públicos e autenticados, uso do terminal para rodar código e gerar artefatos como apresentações e planilhas.

Nos testes, o novo Researcher teve desempenho 44% melhor no benchmark BrowseComp e 6% melhor no GAIA em comparação à versão anterior.

Além disso, diversas medidas de segurança foram implementadas para garantir o uso Enterprise seguro.

O Gemini Deep Research agora pode acessar Gmail, Drive e Chat como fontes para montar relatórios de pesquisa em múltiplas etapas, combinando dados internos com resultados da web. O usuário escolhe quais fontes liberar e pode exportar o output para um documento ou podcast gerado por IA.

O recurso, inicialmente disponível só no desktop, posiciona o Workspace como um grande repositório de conhecimento para agentes de IA, automatizando tarefas como análise de mercado e dossiês de concorrentes.

Também aumenta a pressão por transparência e controles de uso dos dados.

O ByteDance lançou o Doubao-Seed-Code, o agente de codificação de IA mais acessível da China, por apenas US$ 1,30 no primeiro mês (depois US$ 5,50/mês). O modelo alcançou 78,8% no benchmark SWE-Bench Verified, igualando o desempenho do Claude Sonnet da Anthropic, processa até 256 mil palavras por consulta e é compatível com ferramentas populares como Cursor e Cline.

O lançamento acontece seis dias após o ByteDance cortar acesso aos modelos Claude, em resposta às restrições da Anthropic a empresas chinesas, intensificando a guerra de preços em ferramentas de desenvolvimento com IA na China.

A OpenAI lançou o Aardvark, um agente de segurança baseado em GPT-5 que simula um pesquisador de segurança: ele analisa repositórios, monitora commits, modela ameaças, identifica vulnerabilidades, testa a explorabilidade em sandbox e sugere correções via Codex.

Em testes internos e com parceiros, o sistema já roda há meses, encontrou vulnerabilidades relevantes e atingiu 92% de detecção em benchmarks de falhas conhecidas e sintéticas.

Além de aplicações internas, a OpenAI planeja oferecer verificações gratuitas para alguns repositórios sem fins comerciais, junto com uma política de divulgação mais amigável a desenvolvedores.

Diante de um cenário com preocupações com segurança cada vez maiores, o Aardvark é apresentado como um modelo de defesa contínua.

MODELOS

A Alibaba lançou o Qwen3-Max-Thinking, um modelo em estágio de preview e ainda em treinamento, que já demonstra desempenho excepcional em tarefas de raciocínio. Mesmo nesta fase intermediária, quando combinado com uso de ferramentas e aumento de recursos computacionais em tempo de teste, o Qwen3-Max-Thinking atinge 100% de acurácia em benchmarks desafiadores como AIME 2025 e HMMT.

O modelo está disponível para teste no Qwen Chat e na API da Alibaba Cloud com a opção "enable_thinking=True". A equipe promete avanços contínuos à medida que o treinamento progride, sinalizando evolução significativa na resolução de problemas complexos.

A OpenAI lançou o GPT-5-Codex-Mini, uma versão mais compacta e econômica do GPT-5-Codex, permitindo aproximadamente 4 vezes mais uso que o modelo padrão, com pequena redução de capacidade. O modelo está disponível na CLI e extensão de IDE para usuários autenticados com ChatGPT, com API em breve.

Indicada para tarefas menos complexas ou quando se aproxima dos limites de uso, a Codex sugere a troca automática ao atingir 90% do limite, permitindo maior tempo de trabalho sem interrupção.

Além disso, melhorias de eficiência aumentaram em 50% os limites de taxa para planos ChatGPT Plus, Business e Edu, enquanto Pro e Enterprise recebem processamento prioritário para máxima velocidade.

*Curadoria de notícias da seção e comentários feitos por Rafael Girolineto, AI expert, parceiro da Snaq e Data & AI Manager da Inspira

Decidir sobre IA nos negócios começa por entender o essencial.

Por isso estamos construindo um programa feito para líderes que precisam entender IA com clareza, para conversar com seus times, fazer escolhas com segurança e preparar o negócio para os próximos meses e anos.

Quer ser avisado em primeira mão? Entre na lista de espera aqui.

Aqui na Snaq, acreditamos que as melhores marcas são aquelas que compartilham conhecimento e se tornam thought leaders para a sociedade!

Quer ser nosso parceiro nessa missão de compartilhar inteligência e educação sobre inovação? Manda uma mensagem pra gente!

O que achou dessa edição? |

Faça Login ou Inscrever-se para participar de pesquisas. |